La dénomination de la troisième étape du cycle du renseignement peut varier selon les auteurs : analyse, traitement, interprétation, etc. Il existe cependant une terminologie propre à cette phase qui est celle d' »exploitation ». Elle est notamment décrite par Franck Bulinge dans son article de recherche « Le cycle du renseignement : analyse critique d’un modèle empirique« , dans lequel il la résume à deux fonctions :

- transposer des données en informations ;

- acquérir des connaissances.

De fait, il s’agit d’un sous-processus du cycle du renseignement qui est constitué de cinq étapes que nous suivrons ici :

- l’évaluation : l’évaluation de la qualité des sources d’information repose d’abord sur l’expérience du veilleur qui évalue leur qualité en fonction des informations qu’il possède et de ses propres connaissances sur le sujet. Ensuite, l’analyse du contenu est effectuée par le veilleur et/ou l’analyste. Si possible en collaboration avec un ou plusieurs experts dont les connaissances partagées permettront un meilleur recoupement des informations collectées.

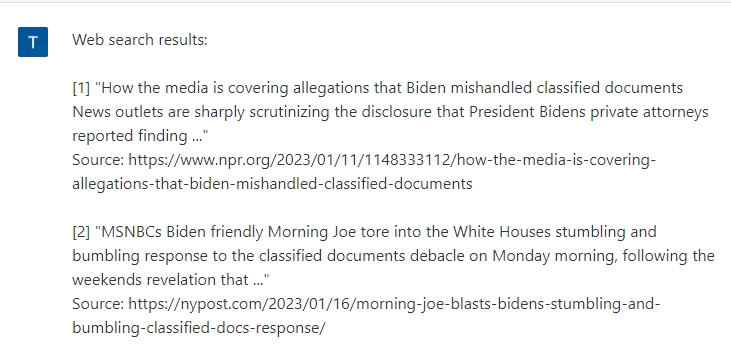

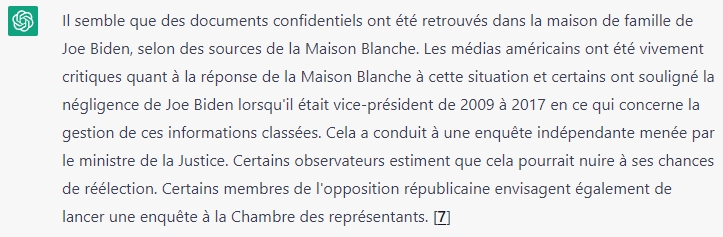

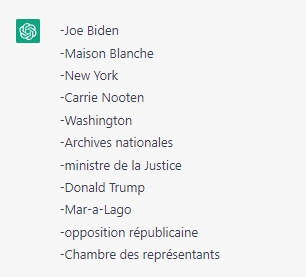

Il est clair que chatGPT n’est pas à son avantage dans cette tâche. En effet, ses nombreuses erreurs factuelles (j’y reviendrai dans le dernier article de cette série) ne permettent pas, pour l’instant, de lui faire confiance pour des recoupements d’informations. Il existe cependant une solution intéressante, qui consiste à passer par l’extension pour Chrome WebChatGPT qui permet de rechercher des contenus récents. Rappelons en effet que ChatGPT n’indexe pour l’instant que des contenus web allant jusqu’à 2021. On peut dès lors lui poser des questions de type : « US media reporting on the issue of Joe Biden’s confidential files » (« médias US qui évoquent la question des dossiers confidentiels de Joe Biden »). Non seulement le service va remonter des articles récents, ce qui pourra aider dans la tâche de recoupement, mais il va également en proposer un bref résumé.

- le traitement : les données collectées, textes, images, photos, vidéos, etc doivent être indexées dans des outils de traitement informatique. Ceux-ci, par le biais d’un formatage spécifique et d’un ajout manuel ou automatique de métadonnées (dates, auteur, origine, etc.), permettent de les stocker de manière efficace et de les exploiter dans des logiciels spécialisés (veille, OSINT, data analysis, dataviz, …). A l’inverse de l’étape précédente, ChatGPT donne ici une bonne idée des nombreuses possibilités que les modèles de langage offriront prochainement, de manière massive, en terme de traitement de données.

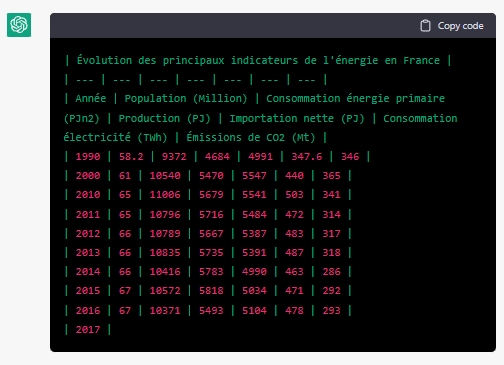

- reformatage de données : on peut, par exemple, lui demander de reformater l’information d’un tableau dont on a simplement copié les données. C’est ce que j’ai fait avec ce tableau issu de la Wikipedia. Voici les données collées en vrac dans chatGPT avec la commande

Convert this in a markdown table. Et voici le résultat formaté par ChatGPT :

Et voici le résultat formaté par ChatGPT :

La syntaxe Markdown est ajoutable dans Word sous réserve de convertir au préalable le document via un service capable de transformer du markdown en .doc comme Cloudconvert (mais il y en a d’autres). - Extraction d’entités : il est possible de lui demander d’extraire les entités nommées d’un document, il s’agit des noms de personnes, de lieux, d’organisations, de produits, etc. Très pratique par exemple pour trouver des tags pour un document. Voici les résultats de ce traitement pour un article de RFI

- classement et navigation dans des corpus de données : il n’est pas encore possible de tester les modèles géants de langage sur de larges corpus de contenus textuels ou autres, mais l’on peut déjà déduire, de ce que l’on voit et teste, qu’il sera possible de leur demander, par exemple, de naviguer dans tel corpus d’images ou de texte, de classer les contenus dans tel ou tel ordre, en croisant plusieurs critères, par exemple de nous donner tous les articles de presse datant d’il y a moins de 24h, qui évoquent le « parlement européen », le Qatar et le Maroc et qui intègrent une vidéo. Et tout cela par des demandes en langage naturel ou à la voix.

- reformatage de données : on peut, par exemple, lui demander de reformater l’information d’un tableau dont on a simplement copié les données. C’est ce que j’ai fait avec ce tableau issu de la Wikipedia. Voici les données collées en vrac dans chatGPT avec la commande

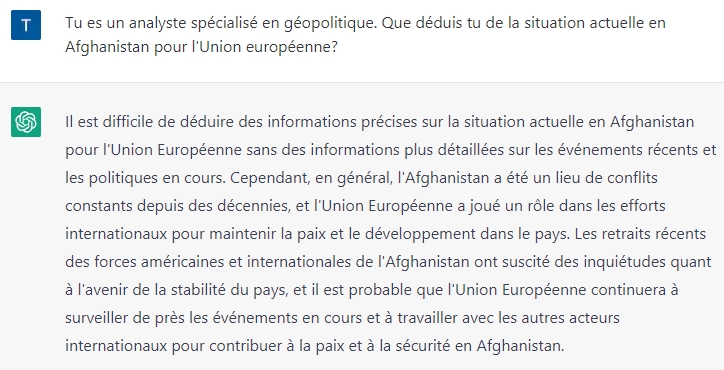

- L’analyse : il s’agit maintenant pour le veilleur ou l’analyste d’interpréter les informations validées pour en extraire des éléments utiles. « Il va dès lors les décomposer, les relier, les comparer et les mélanger entre elles, jusqu’à obtenir des représentations intelligibles et porteuses de sens qu’il identifie comme autant d’hypothèses de situation, signaux faibles ou indices d’alerte » (F. Bulinge). Autant dire que cette phase est la plus problématique tant l’analyse est une qualité profondément humaine. Mais comme toujours, il faut prendre les outils dits d' »analyse » pour ce qu’ils sont vraiment, à savoir des outils d’aide à l’analyse. Et il ne faut surtout pas en attendre plus pour le moment (et probablement pour encore longtemps). Pour les utiliser au mieux, il est recommandé de demander à ChatGPT de jouer un rôle, celui d’un analyste en géopolitique par exemple, ou en « competitive intelligence ». Ou encore celui d’un journaliste spécialisé, d’un consultant, d’un marketeur. Comme nous le disions dans l’article précédent, ce qui compte est de bien rédiger sa demande, ou prompt. Une des solutions préconisées est de demander à ChatGPT d’assumer une fonction spécifique : journaliste, analyste, consultant; marketeur,… Voici un exemple de demande simple : « Tu es un analyste spécialisé en géopolitique. Que déduis tu de la situation actuelle en Afghanistan pour l’Union européenne? ».

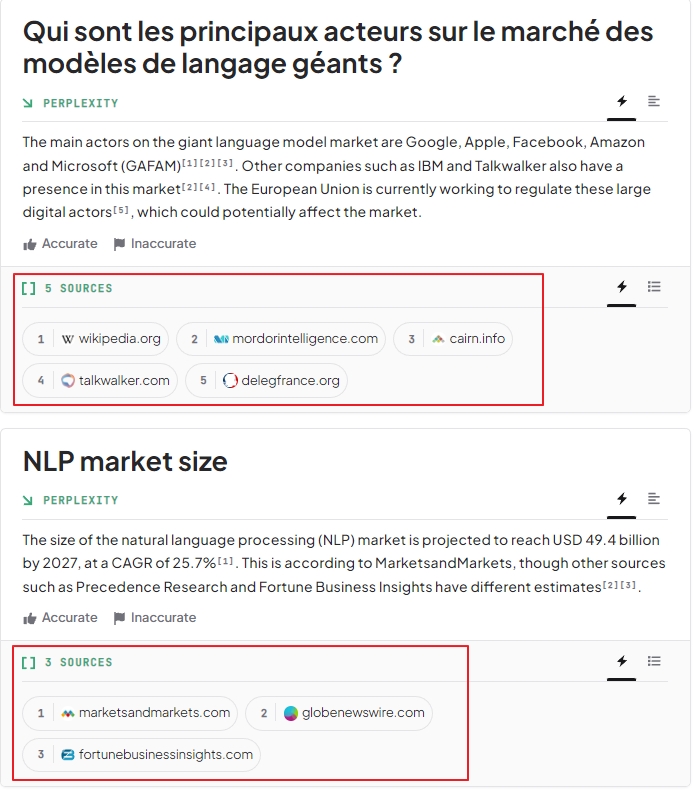

Évidemment, cela ne fonctionne pas très bien sur ChatGPT dont les contenus les plus récents datent de 2021. En revanche, cela devient plus intéressant avec Perplexity dont on rappelle qu’il va chercher des contenus sur le web avant de les synthétiser :

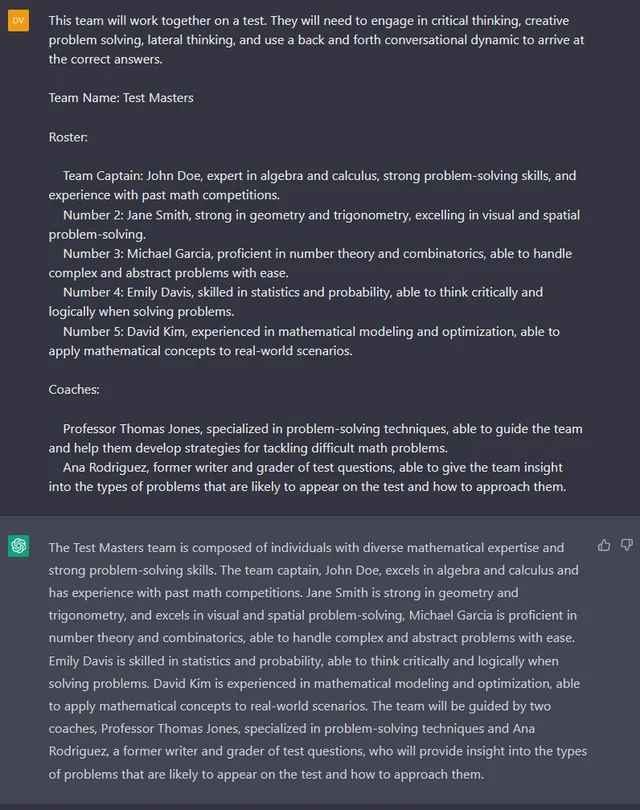

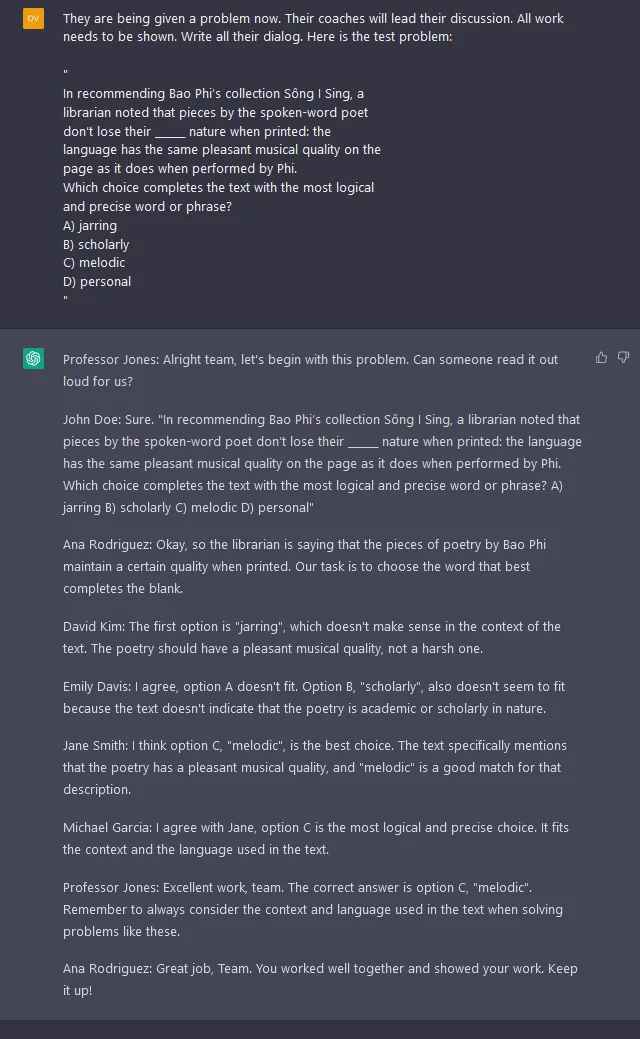

Mais l’on peut tenter d’être encore plus créatif en utilisant ChatGPT pour résoudre des problèmes en équipe virtuelle pratiquant la pensée critique et latérale. Il sera intéressant alors de définir un rôle et des compétences spécifiques pour chaque membre de l’équipe. C’est ce qu’a tenté cet utilisateur :

Les questions qu’il a posées, une fois ce cadre défini, peuvent être trouvées ici. En voici une :

ChatGPT peut également se révéler très pratique pour aider à se poser les bonnes questions sur un thème de travail afin d’être certain de ne pas passer à côté de quelque chose. C’est d’ailleurs en partie comme cela que l’agence IARPA, responsable de la recherche avancée en matière de renseignement pour les agences gouvernementales américaines, prévoit d’utiliser les modèles de langage.

Exemple : En tant qu’analyste spécialisé en géopolitique, quelles questions te poserais-tu pour comprendre les enjeux de la guerre russe en Ukraine?

Réponse :

- Quels sont les objectifs de la Russie dans cette guerre?

- Quels sont les principaux groupes armés impliqués dans le conflit?

- Quels sont les principaux moyens militaires utilisés par la Russie et l‘Ukraine pour mener leurs batailles?

- Quels sont les principaux alliés de la Russie et de l‘Ukraine dans ce conflit?

- Quels sont les principaux accords de cessez–le–feu et de paix signés entre la Russie et l‘Ukraine?

- Quels sont les principaux problèmes économiques et politiques qui sous–tendent cette guerre?

- Quels sont les principaux problèmes humanitaires qui découlent du conflit?

- Quels sont les principaux défis auxquels se confrontent actuellement l‘Ukraine et la Russie pour parvenir à un règlement durable?

Rien de fascinant certes, mais c’est un bon début et bien sûr cela peut s’avérer très utile pour la phase d’orientation des besoins et l’élaboration d’un plan de veille.

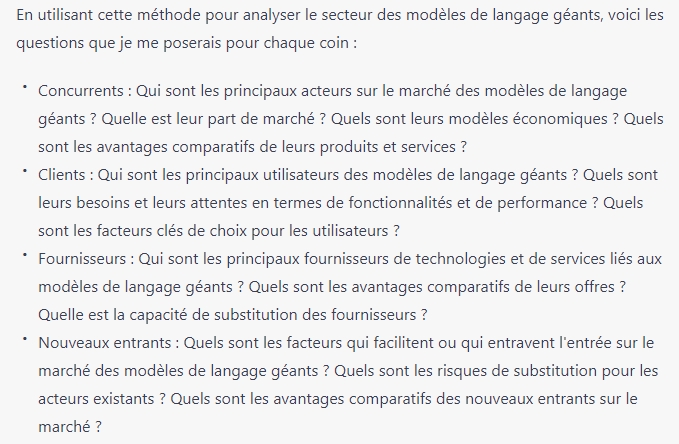

Bien entendu il est également possible d’utiliser les techniques d’aides à l’analyse déjà présentées dans la partie 1 (SWOT, PESTEL,…) pour mieux comprendre un environnement. Un exemple avec la méthode de « four corners » de Porter :  Bon, ChatGPT s’est un peu embrouillé dans les méthodes mais les questions posées sont globalement pertinentes. Il sera ensuite possible de les « creuser » en relançant les plus intéressantes et en n’oubliant pas d’activer WebchatGPT pour obtenir des résultats récents. On pourra également se retourner vers Perplexity.ai, déjà évoqué, qui quoi qu’alimenté aussi par l’API d’Open AI, propose des résultats concrets et sourcés.

Bon, ChatGPT s’est un peu embrouillé dans les méthodes mais les questions posées sont globalement pertinentes. Il sera ensuite possible de les « creuser » en relançant les plus intéressantes et en n’oubliant pas d’activer WebchatGPT pour obtenir des résultats récents. On pourra également se retourner vers Perplexity.ai, déjà évoqué, qui quoi qu’alimenté aussi par l’API d’Open AI, propose des résultats concrets et sourcés.

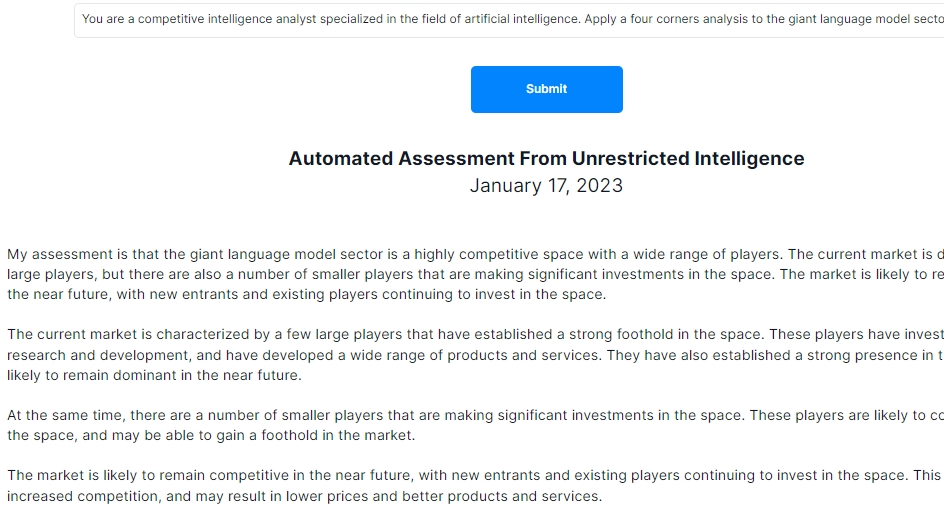

Mais il est déjà envisageable de voir plus loin avec des modèles qui auront été entraînés sur des corpus thématiques spécifiques et proposeront de l’aide à l’analyse optimisée. Unrestricted Intelligence est un prototype qui va en ce sens. Il propose une « analyse » des problèmes que vous lui soumettez, ainsi qu’une liste de questions complémentaires et d’étapes à suivre. Bien que ses résultats doivent être pris avec tout le recul nécessaire, le service donne une bonne idée de ce qui émergera (déferlera?) prochainement. Exemple :

- la synthèse : Il s’agit de l’opération inverse c’est-à-dire que le veilleur ou l’analyste a intégré les nouvelles informations à ses propres connaissances durant la phase précédente et doit maintenant les restituer de manière pertinente en fonction de sa propre interprétation. En l’état, cette partie n’est pas plus délégable à l’IA que la précédente. Cependant, là encore il faut voir les modèles de langage comme des assistants et rien de plus. Pourquoi? Parce qu’une synthèse est nécessairement le résultat de la compréhension d’un expert, qui utilise ses connaissances et son angle d’approche spécifique pour la produire. Mais son expertise se manifeste aussi par sa capacité à répondre aux besoins spécifiques des personnes concernées, en se basant sur les informations et l‘expérience préalable qu‘il a de leurs besoins informationnels.

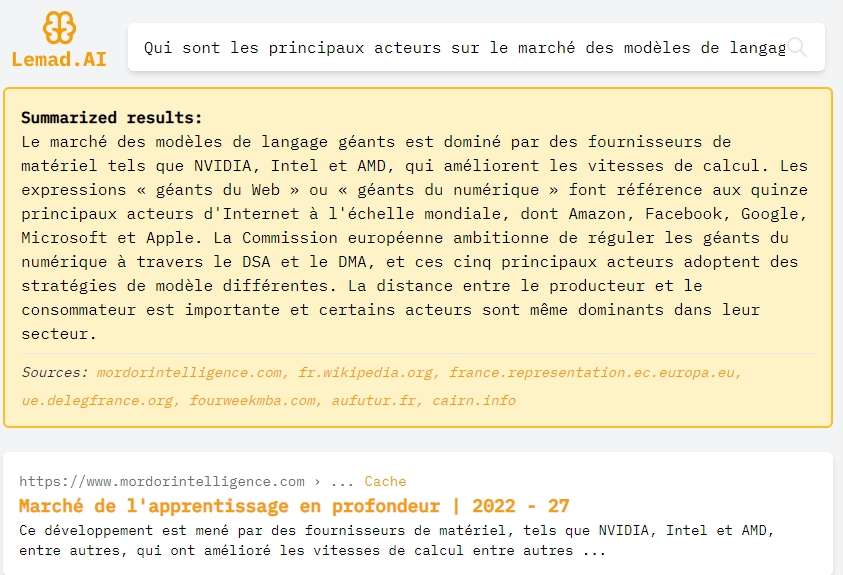

Parmi les fonctionnalités intéressantes allant en ce sens, proposées par les modèles de langage, il y a la possibilité de résumer un corpus documentaire, ou d’attirer l’attention de l’analyste sur un schéma, des récurrences et similarités. S’il n’est pas encore possible de tester ces services sur des corpus internes (simple question de temps) il est en revanche possible d’utiliser l’extension ou le service en ligne Lemad.ai pour en comprendre le potentiel. A l’instar de Perplexity, ils permettent de lancer des recherches dans Google, puis rédigent une synthèse des résultats obtenus.

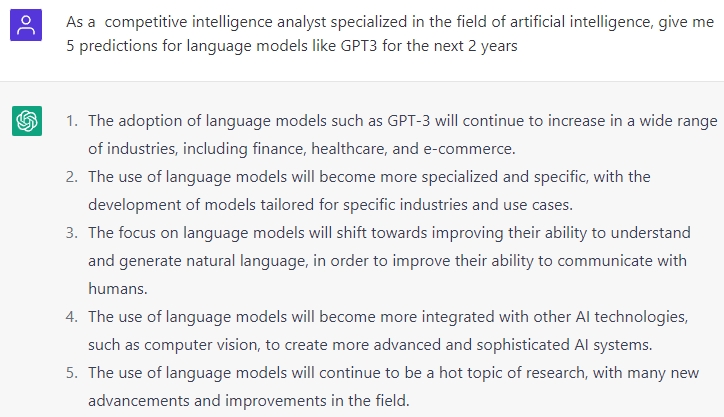

On imagine aisément un outil similaire qui permettrait au veilleur ou à l’analyste de lui résumer en 1000 mots maximum les remontées quotidiennes de la plateforme de veille sur la thématique X. - l’interprétation : lors de cette phase, la dernière avant de passer à l’action, il s’agira de mettre en perspective la connaissance nouvellement synthétisée pour la rendre opérationnelle. Cela implique la construction d’hypothèses et de scénarios qui seront proposés aux décideurs et l’on entre ici dans le domaine de la prévision. ChatGPT est déjà capable d’en fournir, même si, nous le répétons, il faut absolument prendre de la distance concernant ses propositions. Voici un premier exemple de question posée à ChatGPT :

La même question posée à, son grand frère, GPT3 :

En tant qu’analyste de veille concurrentielle spécialisé dans le domaine de l’intelligence artificielle, donnez-moi 5 prédictions pour les modèles de langage comme GPT3 pour les 2 prochaines années

-

1. Les modèles linguistiques comme GPT3 deviendront de plus en plus puissants et efficaces, ce qui leur permettra de s’attaquer à des tâches plus complexes et de générer des résultats plus précis.

-

2. Les modèles de langage comme GPT3 seront plus largement adoptés et commenceront à être utilisés dans une gamme d’applications allant du traitement du langage naturel au service client automatisé.

-

3. On assistera à une augmentation du développement de modèles de langage spécialisés, adaptés à des tâches et des domaines spécifiques.

-

4. Au fur et à mesure que les modèles de langage deviendront plus puissants, ils seront en mesure de générer des interactions conversationnelles plus proches de l’humain, les rendant plus conversationnelles et engageantes.

-

5. À mesure que les modèles de langage deviennent plus sophistiqués, ils seront plus susceptibles d’être utilisés dans le développement d’applications d’apprentissage automatique capables de comprendre le langage naturel.

-

Comme nous l’avions déjà indiqué dans les précédents articles, il est intéressant de réitérer la même demande et de la soumettre à différents modèles de langage pour obtenir des résultats variés. De fait, il existe déjà au moins un service optimisé pour la prévision assistée, Praline.ai qui n’est encore qu’en version démo, mais offre un aperçu intéressant de ce que pourrait être le prédictif « pousse-bouton » pour tous. Nous y reviendrons prochainement.

L’on voit donc que même si ChatGPT est loin d’être abouti dans cette phase d’exploitation, son potentiel est important et je n’ai aucun doute que, même si cela peut inquiéter ou faire sourire, les modèles de langage seront poussés en ce sens. La course à la collecte de données depuis une quinzaine d’années par les grands acteurs de l’industrie, du marketing, de la publicité et bien sûr du renseignement, ont besoin de technologies permettant de les rendre intelligibles et exploitables par le plus grand nombre et transformer ainsi les professionnels de la veille et du renseignement en « analystes augmentés ». Les modèles de langage joueront ce rôle d’interface avancée, et bientôt d’assistant individuel tel le Domino de Michaelmas. Pour le meilleur et pour le pire.

Image générée par Midjourney.

A NOTER : je me concentre pour l’instant sur l’exploration des usages potentiels des modèles de langage. Le dernier article de cette série reviendra bien évidemment sur leurs limites et les risques qu’ils sont susceptibles de faire courir aux veilleurs et analystes.

A NOTER : j’ai mis en place une page web sur laquelle je partage les « outils » permettant d’intégrer chatGPT au quotidien (extensions, plugins, etc). Et il y en a de nouveaux tous les jours…

1 commentaire